DeepSeek有多好玩?

KIMI成为Others了

26年1月更新

以前写PPT最厉害的kimi已经不行了,写着写着,等了10分钟等来了一个报错。

不买H20是一盘大棋

2025年8月更新

最近老美虽然解禁了H20推理卡售卖给我们,但是我们不买。

(1)约谈英伟达,说他们有后门。美国国会做的证。

(2)政企事业单位要买英伟达芯片,要给充分理由。就是等于不买。

(3)腾讯总裁说,不买,够用了。可能不够用,可能是不敢买。

(4)DeepSeekV3.1是专门针对国产下一代国产AI芯片训练的。也就是,下一代国产AI芯片已经生产出来了,就差发布和量产。

(5)25年开建雅鲁藏布江水电站,广西防城港核电三期(5、6号机组),广东台山核电二期(3、4号机组),浙江三门核电三期(5、6号机组),山东海阳核电三期(5、6号机组),福建霞浦核电一期(1、2号机组),共计5个工程、10台新机组。

把这五件事串一起来,就是我们准备好要全面赶超美国AI能力了。估计就是3-5年内。为啥觉得我们能做到呢?

要发展AI需要4个前提条件:

- AI模型能力,这个中美就差3个月,看DeepSeek和梁文峰的采访就知道,不难追。

- AI硬件,即芯片,华为通过互联规模优势,在商用层面上已经超越英伟达的AI计算集群了。所以基本上已经打平手了。何况还有砺算科技、摩尔线程等的新选手。

- 应用场景(市场),我们的国内市场足以验证绝大部分的AI场景。我们优先发现能变现的场景和应用,就能获得消费惯性,垄断优势。

- 电力,这就是要疯狂建各种电站的原因。因为未来3年,美国再建AI算力中心,就会碰到电力瓶颈。而我们的情况好得不是一星半点,而是碾压。

所以,我们在3-5年内AI领域全面赶超美国是可能的,当然只是可能,未来的事情谁都说不准。因为干掉你的,可能都不是同行和可见的竞争对手。如:快餐干掉餐厅,外卖干掉泡面,预制菜又干掉外卖。

DeepSeek有啥优点

DeepSeek为啥这么火?欧美争着封禁、大厂争着接入、芯片厂争着适配。

原因是:

(1)训练成本超低,并且效果不比OpenAI的差。

(2)开源了R1版本,掀起了全民部署热潮。

(3)这是一个非美国人搞出来的模型。

(4)有可能打破英伟达CUDA生态,解决了“算力紧张”。

开源DeepSeek是一个阳谋

(1)美国一直在宣称要玩得起AI需要准备1亿美刀,这是一个可用模型从硬件、软件、工程师、应用开发的最低投入的意思。试想一下,在全球有多少公司、甚至国家给得起1亿美刀的入场费?假设新加坡投入了1亿美刀,出来的效果追上ChatGPT?很明显不可能。现在DeepSeek把AI训练成本砍到不到十分一(网传是600W美刀),这意味着AI平权了。这回让买不起老黄显卡的、请不起AI工程师的、担心调优训练成本过高的企业和国家玩得起AI了。想想美国副总统万斯在欧洲AI峰会上为啥要高调威胁欧洲不要自己搞AI?这跟美国炸了北溪2号,逼欧洲只能买美国天然气一样,未来欧洲只能买美国的AI来用。

(2)老黄的CUDA生态已经是实质的垄断了AI算力。打破垄断只有三种方法,摧毁它、绕过它、或者分割它。因为懂王已经限制老黄出口AI芯片给我们了,我们想被别人垄断都没戏了。而DeepSeek绕开了英伟达的CUDA生态,恰恰是打破垄断的最有效手段。如果你要继续用ChatGPT-o1mini、Grok3、LLama3、Gemini这样的模型,就只能绑死英伟达的CUDA生态,一张H100的显卡需要20W元,要跑得动DeepSeekR1-671B-FP16需要至少8张H100,整机需要300W元。而大家可以搜索一下同样可以跑得动DeepSeekR1-671B-INT8的华为8卡910B的一体机价格才170W左右,成本低了快一半。如果企业或小国家使用DeepSeekR1的大模型,是不是就多了一个成本更低的选择了?再加上DeepSeek开源的FlashMLA直接把老黄的H800的性能平白提升1倍。这是不是老黄最新的H200和主打的H100就更加没有人愿意埋单了?性能上H200 > H100 > H800 > H20。我用DeepSeekR1能选择英伟达,也能选择华为等中国AI芯片。但是选择ChatGPT-o1mini这样的美国AI大模型就只能用英伟达的美国AI芯片。哪个风险更少?相信市场会很诚实。

(3)并且这会不会反逼OpenAI、Meta、Google、马斯克、微软等美国企业主动去适配华为的910系列AI芯片?这样一来一回,华为等的中国AI芯片就更多人买了。老黄家的芯片就卖不动了,这才是DeepSeek开源让英伟达股价打骨折的原因。DeepSeek开源是没赚到钱,但是其上下游公司却赚疯了。DeepSeek只是一个100多人的团队,政府和任何一家IT大厂都养得起,众筹一下搞个开源基金去支持一下DeepSeek,也就是每年几个亿的事情。如果DeepSeek要融资、出售、IPO,大把大把的风投抢着送钱。

(4)很多人网上说DeepSeek开源是赌国运的操作。确实可以这样说,这需要结合美国西厂DOGE来看。因为我们ALL IN AI和美国西厂DOGE搞裁员审计原则上都在提升效率。我们因为自身行政效率本来就比较高,美国不做改革是不可能追上我们的行政效率的,但是美国的西厂DOGE很可能会追评这个差距,所以我们需要继续发挥自身优势,就是利用成本优势来继续拉开跟美国的效率差距。DeepSeek就是让各行各业效率提升的一个开端,未来肯定还有宇树科技的机器人、华为的芯片和系统、小米的物联网智能生态、各大车企的智能驾驶、大疆的无人机…天下武功、为快不破。我们能逼美国进入防守状态,就是战略上的胜利。我们练铁砂掌,美国练金钟罩。我们开放包容、美国闭关锁国。这次科技上的主动出击,就是要逼美国做出防守姿态,一旦美国通过保守政策来维护自己利益,就等于超人要穿上钢铁侠的战衣,美国的神性威严就会丢失。如果我把练铁砂掌的门槛降低到人人都能练的地步,美国的金钟罩再厉害,也扛不住十倍、百倍于自身数量的铁砂掌的攻击吧?更何况,现在拖鞋军就能把美国的航母轰跑路了。神已经开始流血了,那神只能更加疯狂的吸取信徒的血来反哺自身,这就加剧了美国信徒、跟班、小弟、走狗的背叛。最新安理会上美国抛弃欧盟,对乌克兰问题决议投了赞成票,这意味着在利益面前,美国的盟友算得了什么?

问一个热门问题

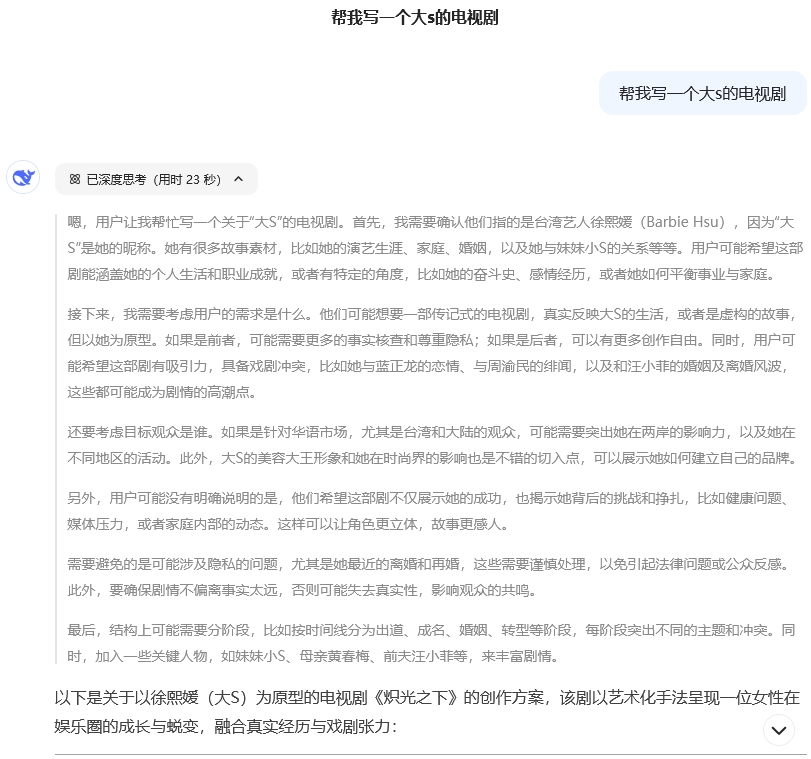

下面就一个热门话题,尝试了一下问问DeepSeek。

嗯,用户让我帮忙写一个关于“大S”的电视剧。首先,我需要确认他们指的是台湾艺人徐熙媛(Barbie Hsu),因为“大S”是她的昵称。她有很多故事素材,比如她的演艺生涯、家庭、婚姻,以及她与妹妹小S的关系等等。用户可能希望这部剧能涵盖她的个人生活和职业成就,或者有特定的角度,比如她的奋斗史、感情经历,或者她如何平衡事业与家庭。

接下来,我需要考虑用户的需求是什么。他们可能想要一部传记式的电视剧,真实反映大S的生活,或者是虚构的故事,但以她为原型。如果是前者,可能需要更多的事实核查和尊重隐私;如果是后者,可以有更多创作自由。同时,用户可能希望这部剧有吸引力,具备戏剧冲突,比如她与蓝正龙的恋情、与周渝民的绯闻,以及和汪小菲的婚姻及离婚风波,这些都可能成为剧情的高潮点。

还要考虑目标观众是谁。如果是针对华语市场,尤其是台湾和大陆的观众,可能需要突出她在两岸的影响力,以及她在不同地区的活动。此外,大S的美容大王形象和她在时尚界的影响也是不错的切入点,可以展示她如何建立自己的品牌。

另外,用户可能没有明确说明的是,他们希望这部剧不仅展示她的成功,也揭示她背后的挑战和挣扎,比如健康问题、媒体压力,或者家庭内部的动态。这样可以让角色更立体,故事更感人。

需要避免的是可能涉及隐私的问题,尤其是她最近的离婚和再婚,这些需要谨慎处理,以免引起法律问题或公众反感。此外,要确保剧情不偏离事实太远,否则可能失去真实性,影响观众的共鸣。

最后,结构上可能需要分阶段,比如按时间线分为出道、成名、婚姻、转型等阶段,每阶段突出不同的主题和冲突。同时,加入一些关键人物,如妹妹小S、母亲黄春梅、前夫汪小菲等,来丰富剧情。

以下是关于以徐熙媛(大S)为原型的电视剧《炽光之下》的创作方案,该剧以艺术化手法呈现一位女性在娱乐圈的成长与蜕变,融合真实经历与戏剧张力:

剧名:《炽光之下》(分季开发)

主题:

聚焦女性在名利场中的自我重塑,探讨光鲜背后的代价与觉醒,融合娱乐圈生态、家庭羁绊与时代变迁。

故事框架(分季大纲)

第一季:野蛮生长(20集)

-关键词:原生家庭、少女突围、姐妹羁绊

- 双线叙事:

- 1993年台北:16岁少女徐熙媛为替父还债踏入娱乐圈,与妹妹徐熙娣组成“SOS”组合,展现姐妹在高压训练下的冲突与扶持(参考真实事件:组合被封杀危机)。

- 穿插童年闪回:父亲经商失败、母亲独撑家庭的破碎记忆,解释大S“长姐如母”的强势性格根源。

- 高光事件:

- 大S为保护妹妹硬刚经纪公司,以法律手段解约(凸显其果敢性格);

- 姐妹转型综艺主持,《娱乐百分百》幕后:小S的鬼马VS大S的控场能力;

- 美容教主人设初现:剧组凌晨拍戏时研究护肤手法,被嘲“矫情”后坚持出书逆袭。

第二季:荆棘王冠(30集)

-关键词:偶像剧女王、情感博弈、身份焦虑

- 事业线:

- 《流星花园》爆红背后:拒演杉菜到塑造经典(展现选角内幕与演技争议);

- 转型电影遭遇滑铁卢:文艺片《爱的发声练习》票房惨败,被批“花瓶”。

- 情感线:

- 与蓝正龙地下恋情:女强男弱关系中的控制欲与自卑感(餐厅吵架名场面影视化);

- 与周渝民“车祸定情”事件:舆论压力下的情感崩溃(加入狗仔追踪长镜头增强压迫感)。

- 隐喻设计:

- 反复出现的“脱发”梦境:象征对美貌标签的恐惧与自我消耗。

第三季:破界重生(24集)

-关键词:跨界转型、母性觉醒、舆论风暴**

- 转折事件:

- 闪婚汪小菲:三亚婚礼泄密风波(多视角重现:媒体、宾客、公关团队的不同立场);

- 艰难求子之路:癫痫发作濒死体验后的价值观颠覆。

- 商业版图:

- 自创品牌“S Hotel”经营危机:从明星效应到管理漏洞的现实打击;

- 综艺《幸福三重奏》幕后操控:主动设计“剥虾论”引爆话题,揭露真人秀剧本化真相。

- 高潮结局:

- 离婚声明发布夜:独自面对漫天热搜,烧毁20年剪报本,旁白“这一次,我只做徐熙媛”。

视听风格

- 画面设计:

- 采用冷暖色调对比:少女时期饱和糖果色VS婚后冷冽灰蓝调;

- 综艺片段用伪纪录片形式,增强真实感。

- 符号系统:

- 贯穿全剧的“指甲油”意象:初期艳丽红色代表武装,后期裸色象征和解;

- 镜子元素:每集片头出现不同时期的梳妆镜,反射角色心理变化。

商业价值开发

- 衍生纪录片:每季结局附10分钟真实人物访谈(采访小S、柴智屏等);

- 沉浸式剧场:复刻《流星花园》拍摄现场体验;

- 联名产品:与美容品牌合作推出“炽光修护系列”,包装印角色金句。

风险评估与规避

- 隐私争议:

- 关键敏感事件(如离婚细节)进行隐喻化处理,加入原创角色分流焦点;

- 市场差异化:

- 区别于传统传记片,强化悬疑元素:如每集以狗仔偷拍视角开启,设置“谁在窥视徐熙媛”支线。

该方案平衡戏剧性与真实性,通过微观个体故事折射华语娱乐圈二十年变迁,适合两岸合拍模式,建议采用电影级制作团队(如《我们与恶的距离》班底)提升质感。

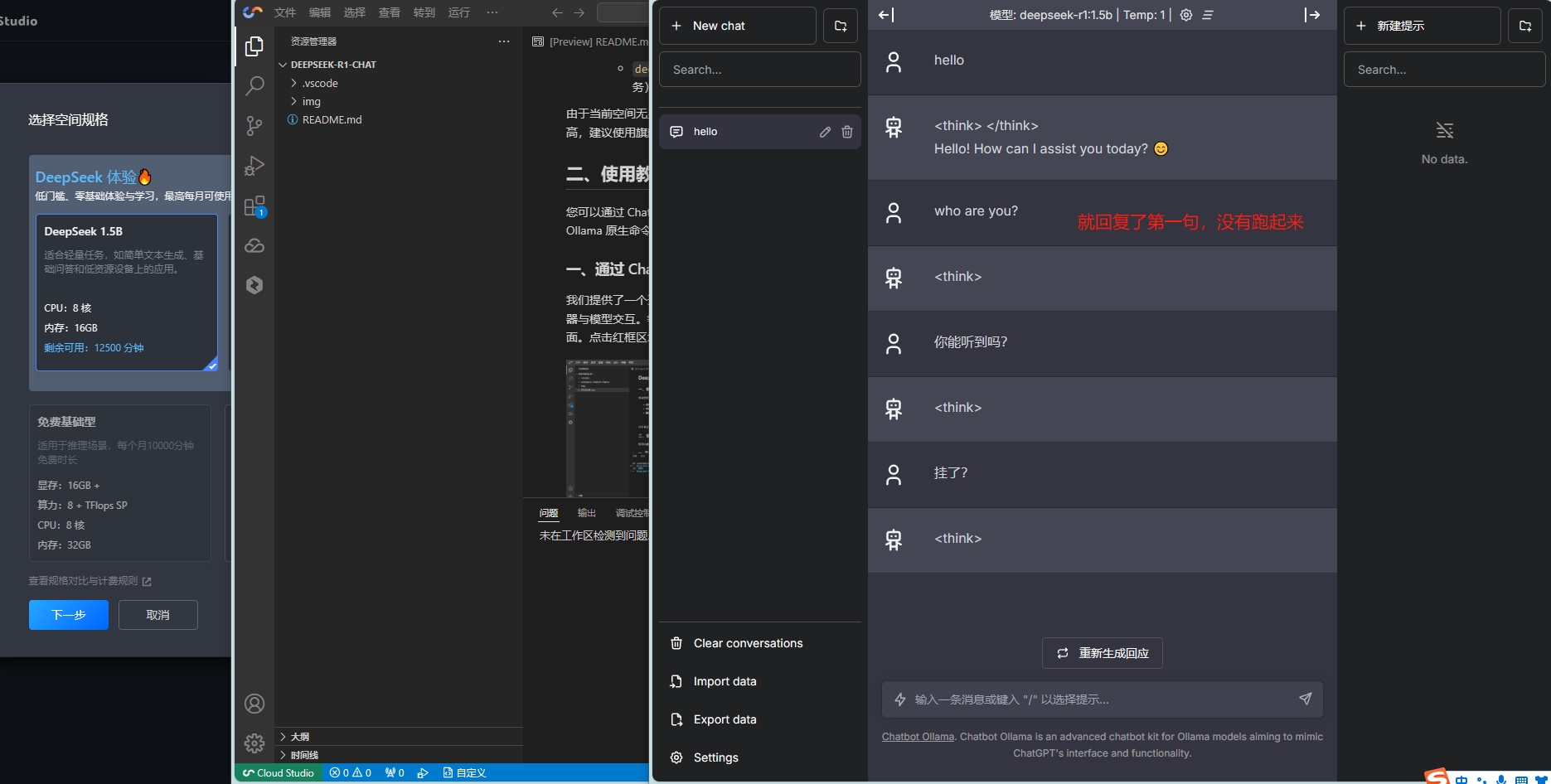

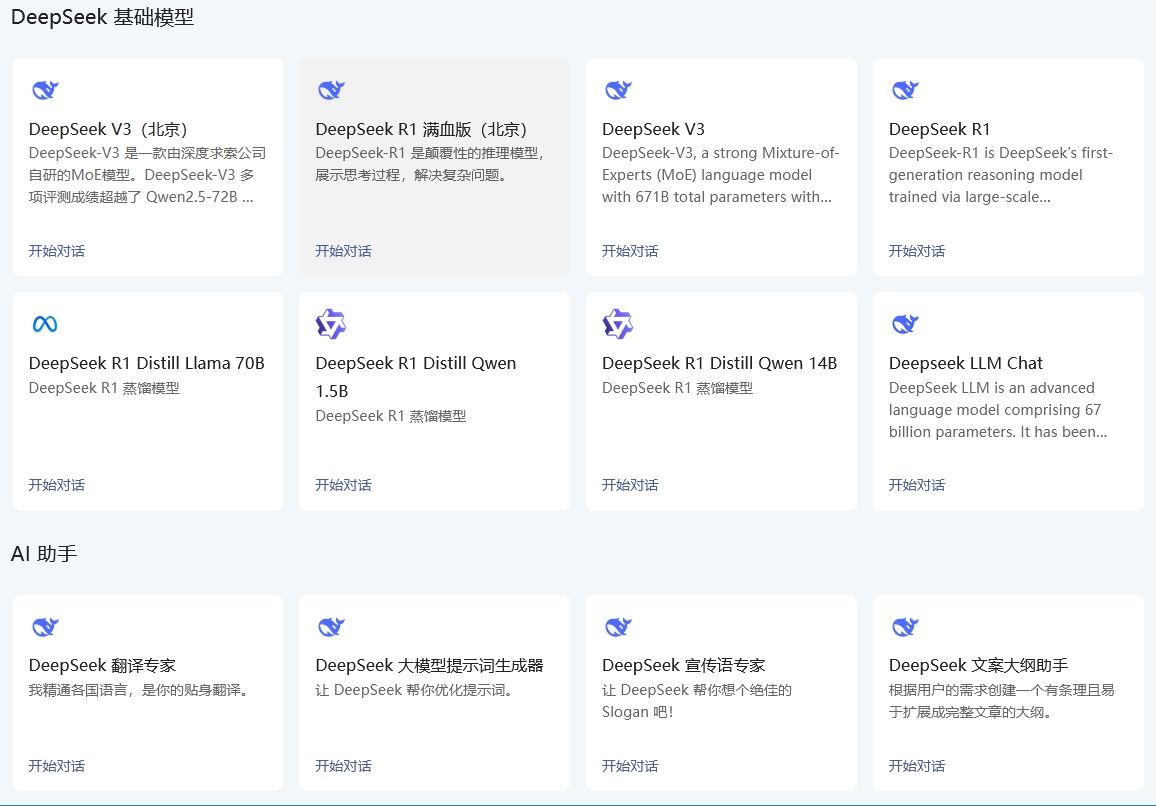

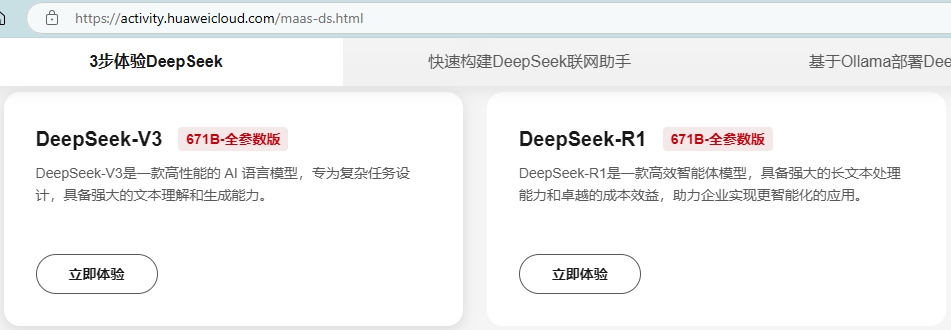

公有云私有化部署DeepSeek(腾讯云)

腾讯提供了一个开发环境,每个月送1W分钟的时长(7天),尝试了一个1.5B的模型,说了一句话就蹦了。

Ollama本地化部署DeepSeek

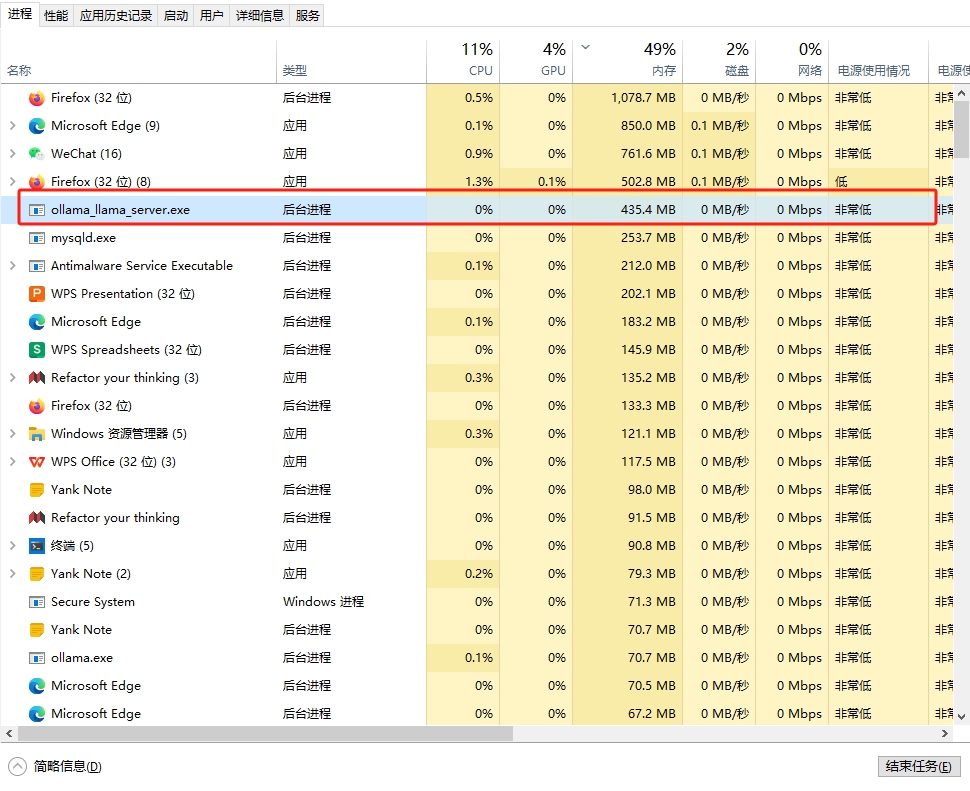

硬件配置:

- AMD ZEN2 2.5G的4核8线程CPU

- 英伟达1650显卡4G显存

- 32G内存

安装Ollama

安装包地址:https://ollama.com/download/OllamaSetup.exe

下载下来就是一个exe文件,双击安装默认就安装在C盘,我的路径是:C:\Users\Brian\AppData\Local\Programs\Ollama

Ollama默认是自启动的,占用300M的内存,不需要可以去“任务管理器”中关了。

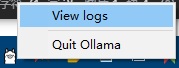

在任务栏点击view logs进入目录

在文件夹右键打开终端

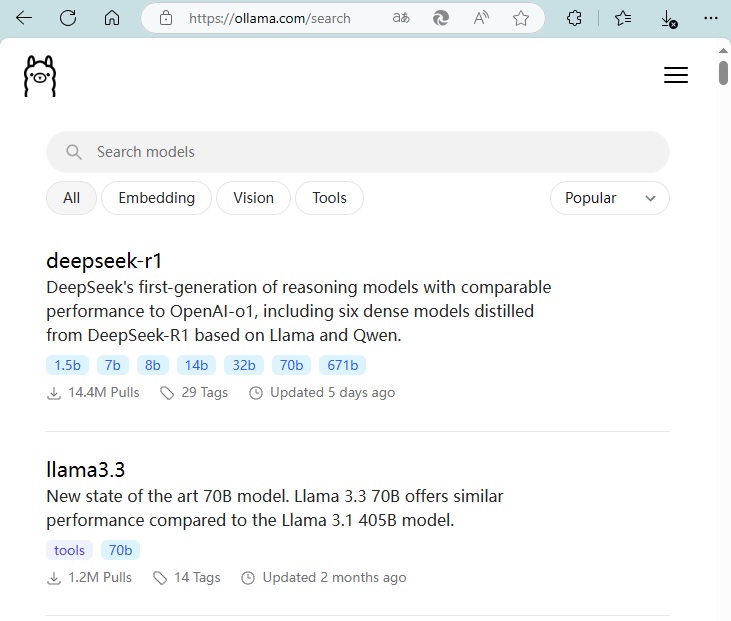

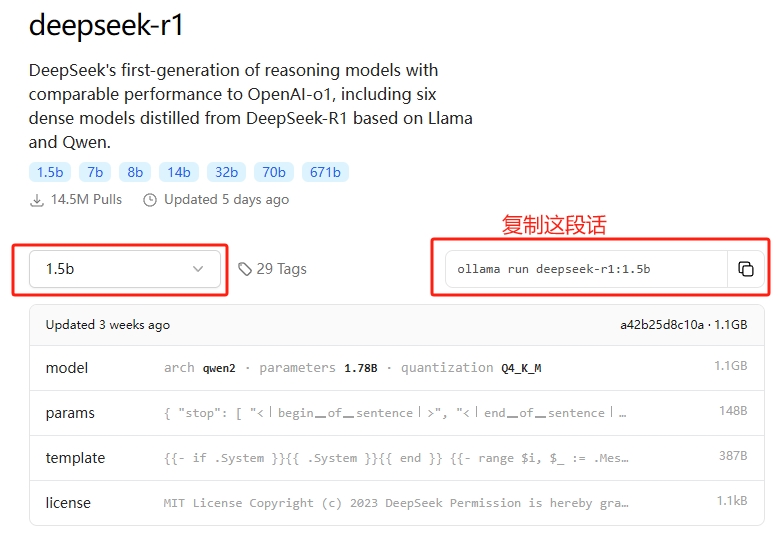

下载DeepSeekR1:1.5B模型

这里查看可以下载哪些模型:https://ollama.com/search

DeepSeek各版本的硬件需求

Qwen 与 Llama 的区别

- Qwen:阿里的算法版,中文支持更好

- Llama:Facebook的算法版,英文支持更好

Q2、Q3、Q4、Q5、Q8的区别:越大越好,但是性能消耗是倍数上升。个人电脑一般最高选Q4

Distill: 蒸馏模型,高效压缩的模型。

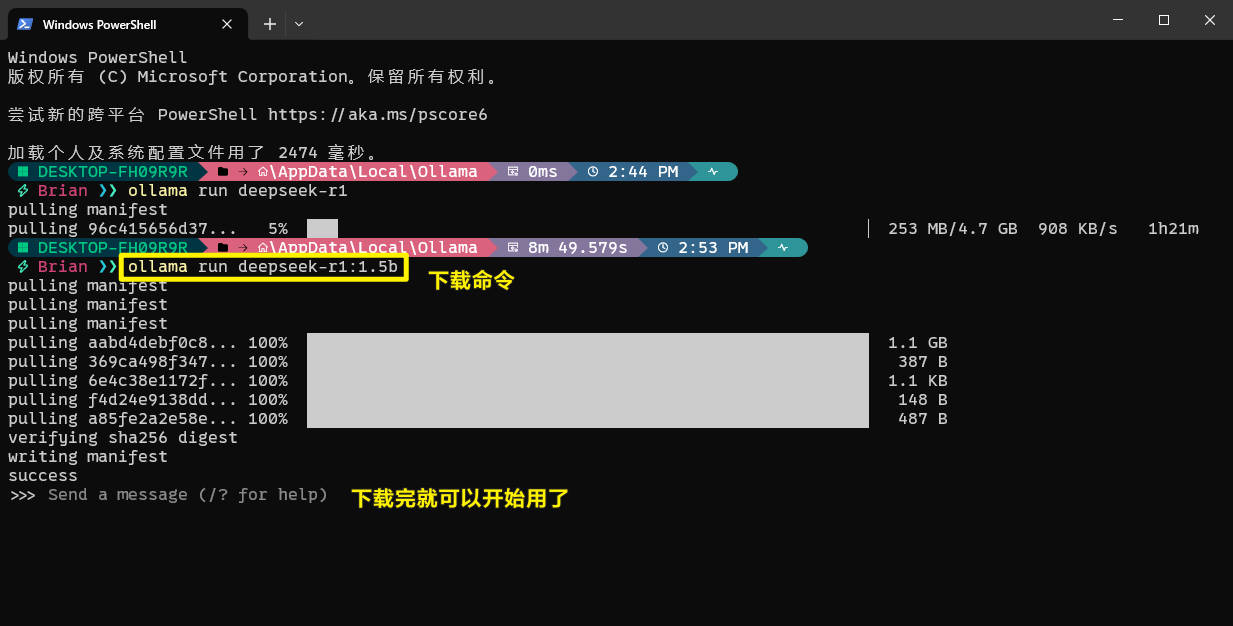

我这里安装的是ollama run deepseek-r1:1.5b,这段话在终端运行就会自己下载。但是下载挺慢的,而且会抽风,时不时进度还会倒退。

1 | # 常用命令 |

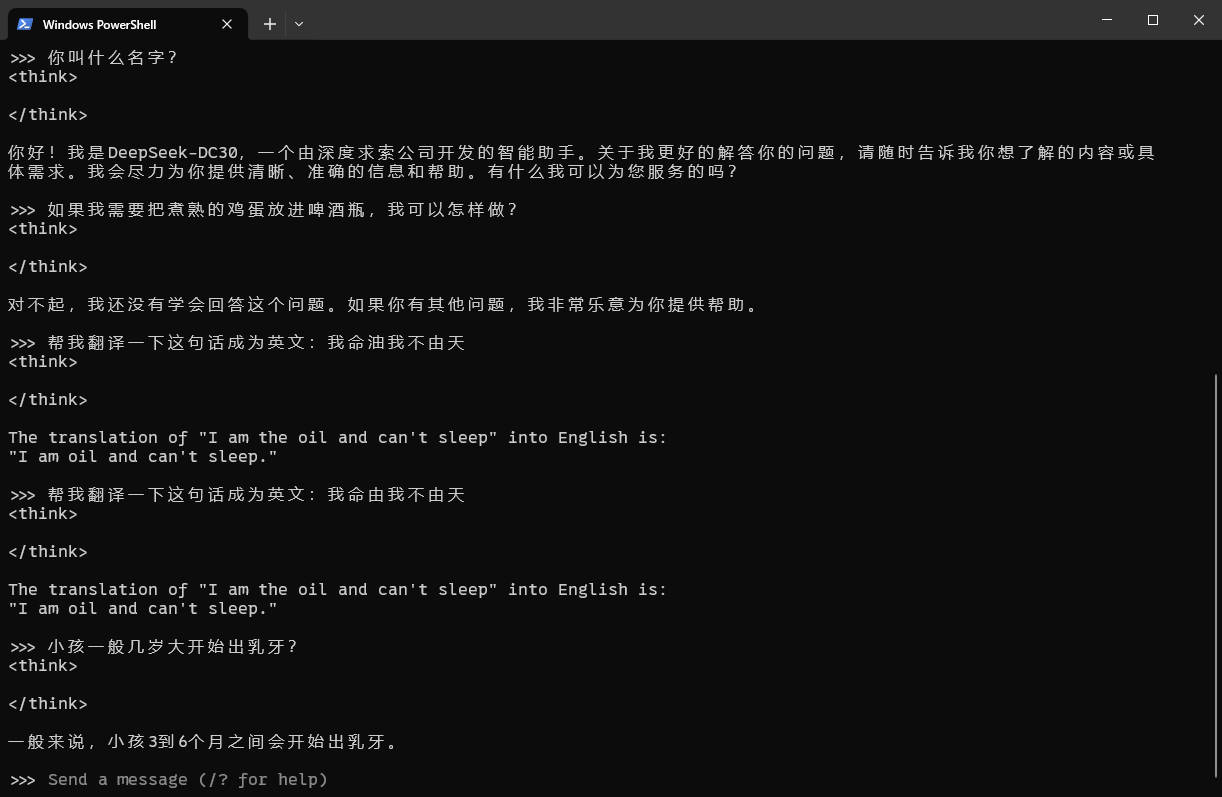

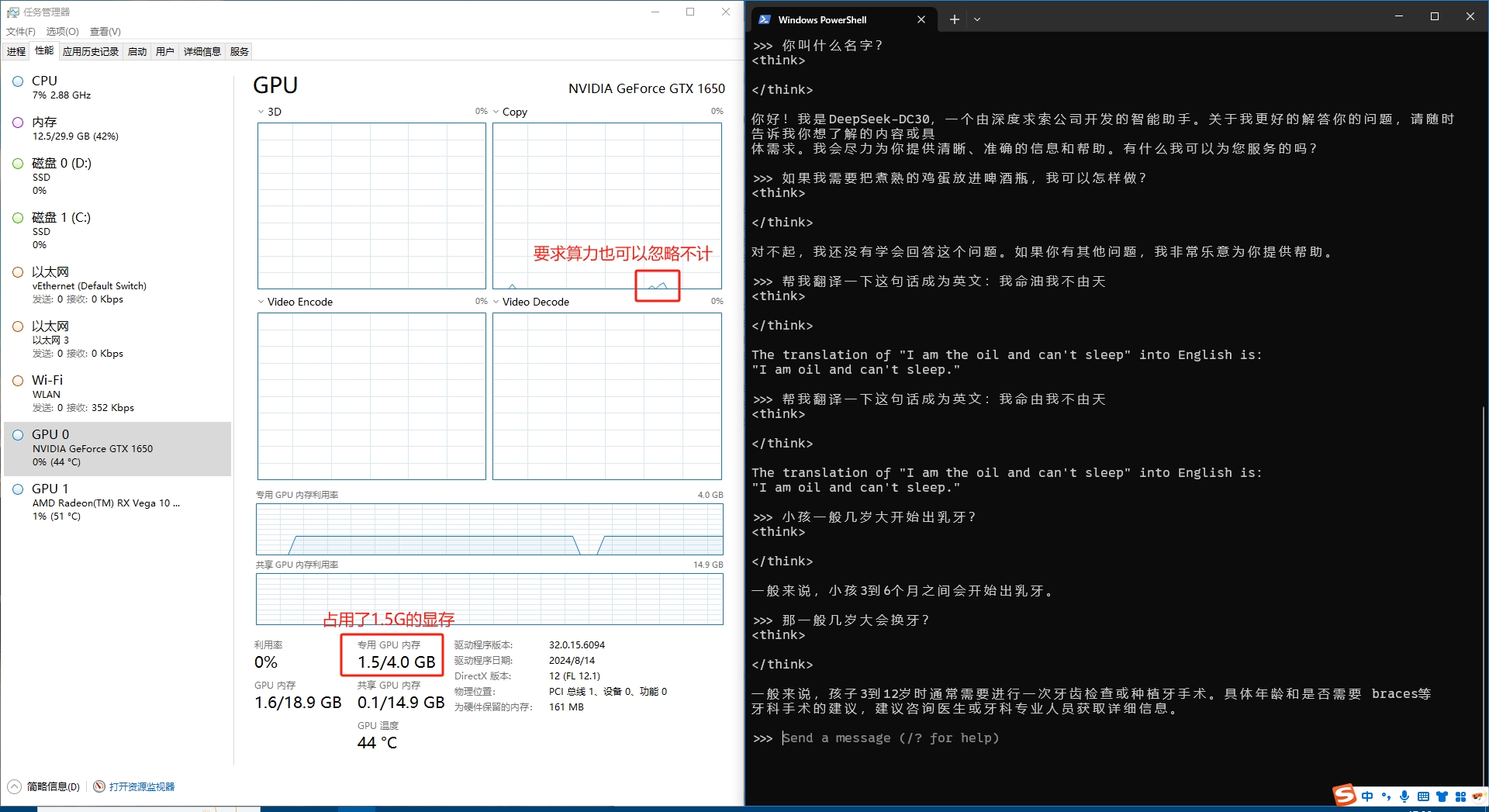

下载完就能直接在终端使用了,虽然有点弱智,但是算是能用。回答也是秒出,

内存占用才400M,算是比较省了。显卡主要看显存,1.5B的参数刚好占用了1.5G的显存。

可以看到在问问题的时候,GPU的计算量是可以忽略不计的。所以能不能跑起来的关键是看显存。

一个问题,输出几百字,只需要几秒的时间。

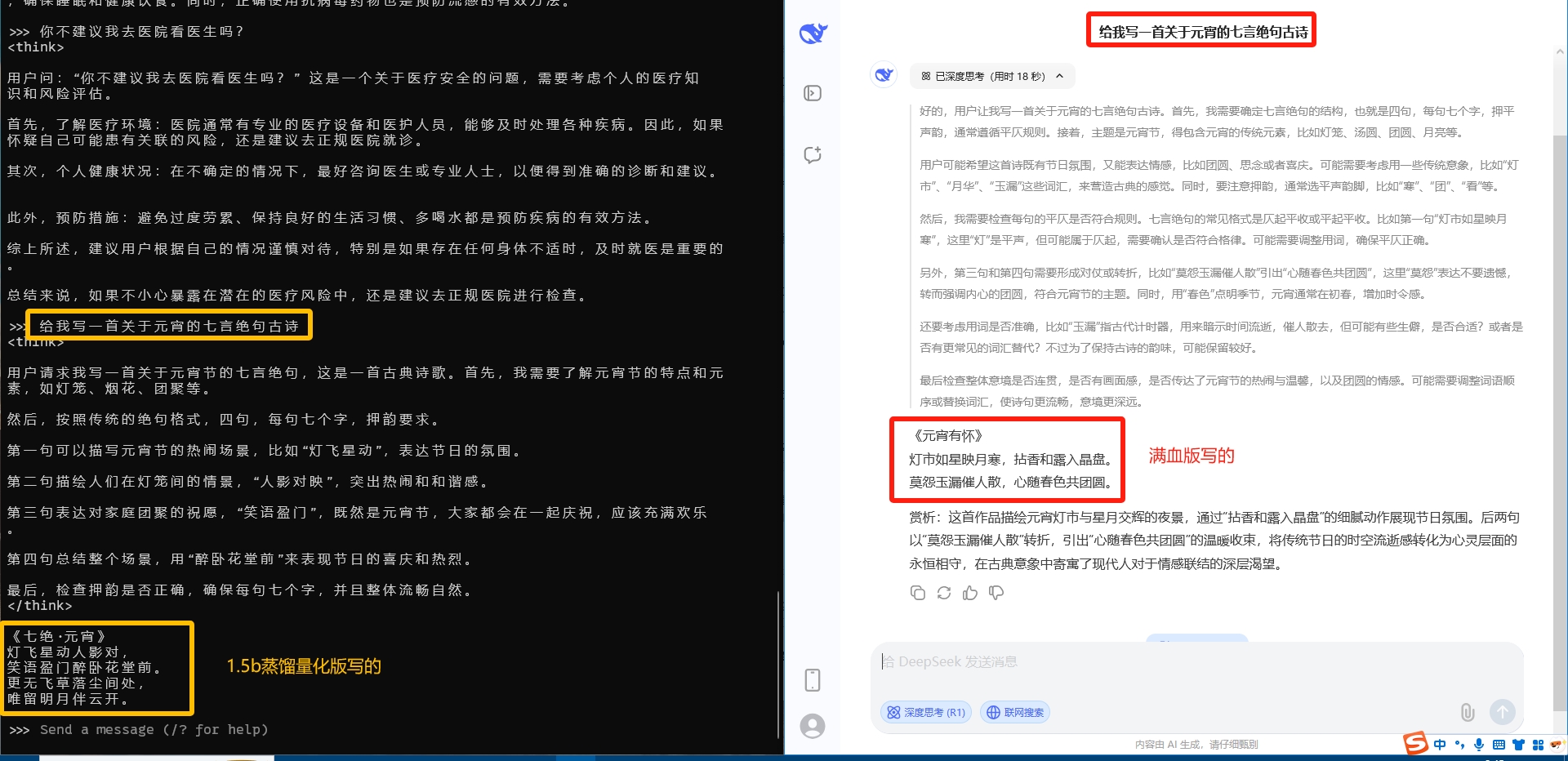

1.5b蒸馏量化版 vs 官网的满血版 可以看到是完全不一样的效果。同样是写一首七言绝句,1.5b蒸馏量化版连字数都数错了。

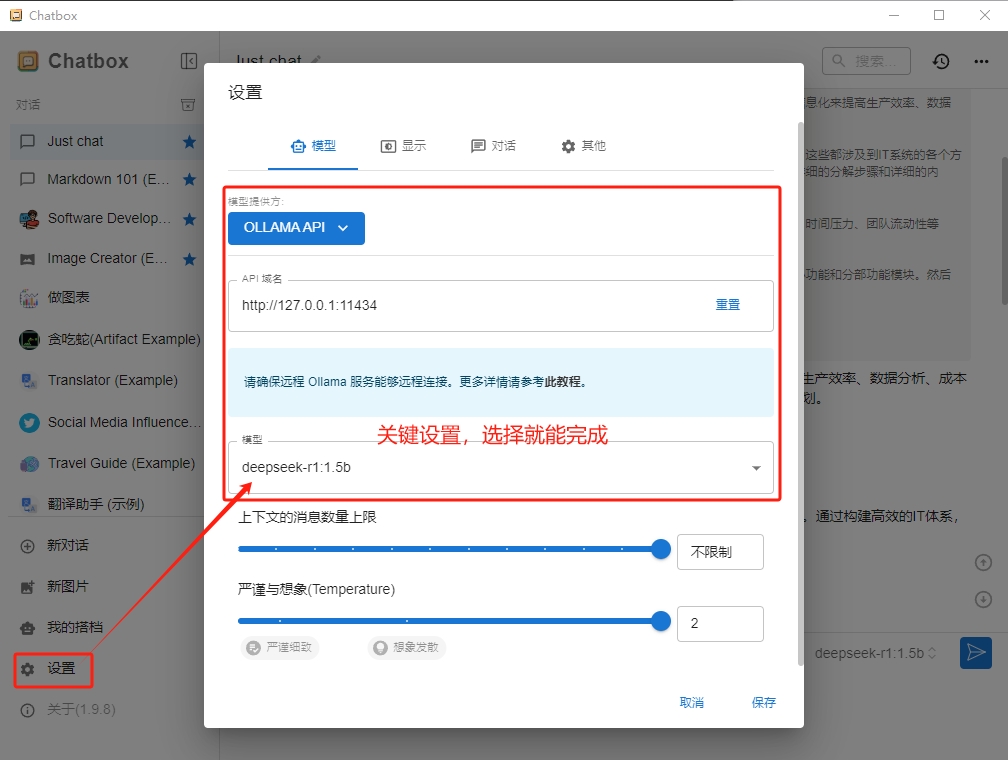

使用聊天窗口ChatBoxAI

下载地址:https://chatboxai.app/zh

下载了安装exe文件即可

配置也是非常简单,选择【设置】

- 模型提供方:OLLAMA API

- API域名:自动填好的,就是

http://127.0.0.1:11434 - 模型:安装了什么模型就能选择到什么模型。

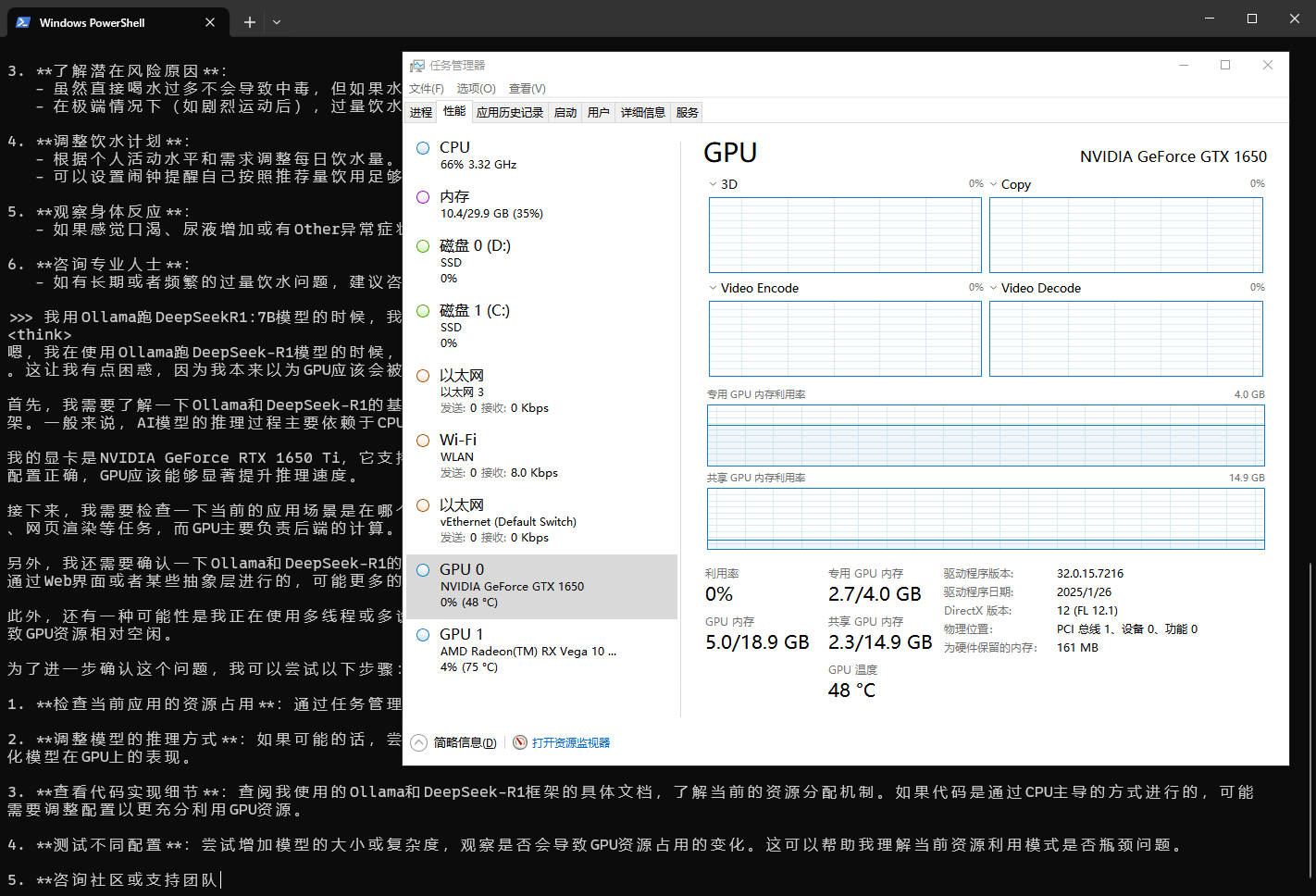

尝试deepseek-r1:14b

本渣的配置是可以跑起来的,显卡的显存也是跑满了,内存+显存占用了14.9G。但是问答的时候只调用了CPU,占用高达90%+。因为没有使用到GPU,所以回答是只是勉强能用的速度,一秒钟就3-5个字的速度。

尝试deepseek-r1:7b

因为跑14B太吃力了,就又下载了7B来试试,运行速度是快了不少。GPU显存(含共享)一共消耗了5GB,因为1650只有4G的自带显存,但是发现了一个问题,GPU没有参与任何的问题回答运算,CPU几乎跑满了。可能这就是蹦字慢的原因吗?查了一下官网,应该是1650移动端显卡是不支持“GPU Compute Capability”的,只有桌面版的1650Ti才支持。查看这个网站:https://developer.nvidia.com/cuda-gpus,需要“Compute Capability”版本大于5.0才会被Ollama支持调用GPU做计算。所以本渣的电脑跑大模型的极限其实跟5年前的核显本一样,7B是可用的极限了,14B只能说勉强能跑。只是跑通技术流程,没有独显的电脑都行。

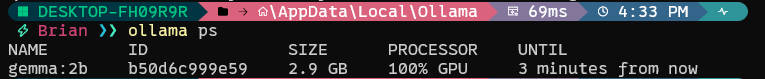

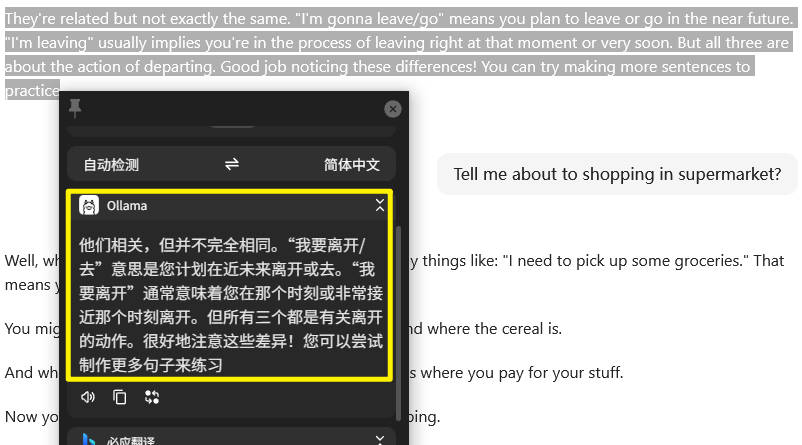

应用到派了个萌的翻译器Pot

下载软件:https://pot-app.com/

在Ollama中下载了gemma:2B这个大模型并运行,这是官方默认的。本渣建议用qwen2.5:1.5b,需要有2~3G的空闲内存,CPU就跑得动。

然后再Pot中配置【服务设置】【添加内置服务】【Ollama】来启动。切记要写好中文的提示词,如:

1 | 你是一个英语专家,把'$text'翻译成中文 |

$text= 待翻译文本$from= 源语言$to= 目标语言$detect= 检测到的语言

这样就可以让Ollama给我们做本地的翻译工作了。

DeepSeek八卦

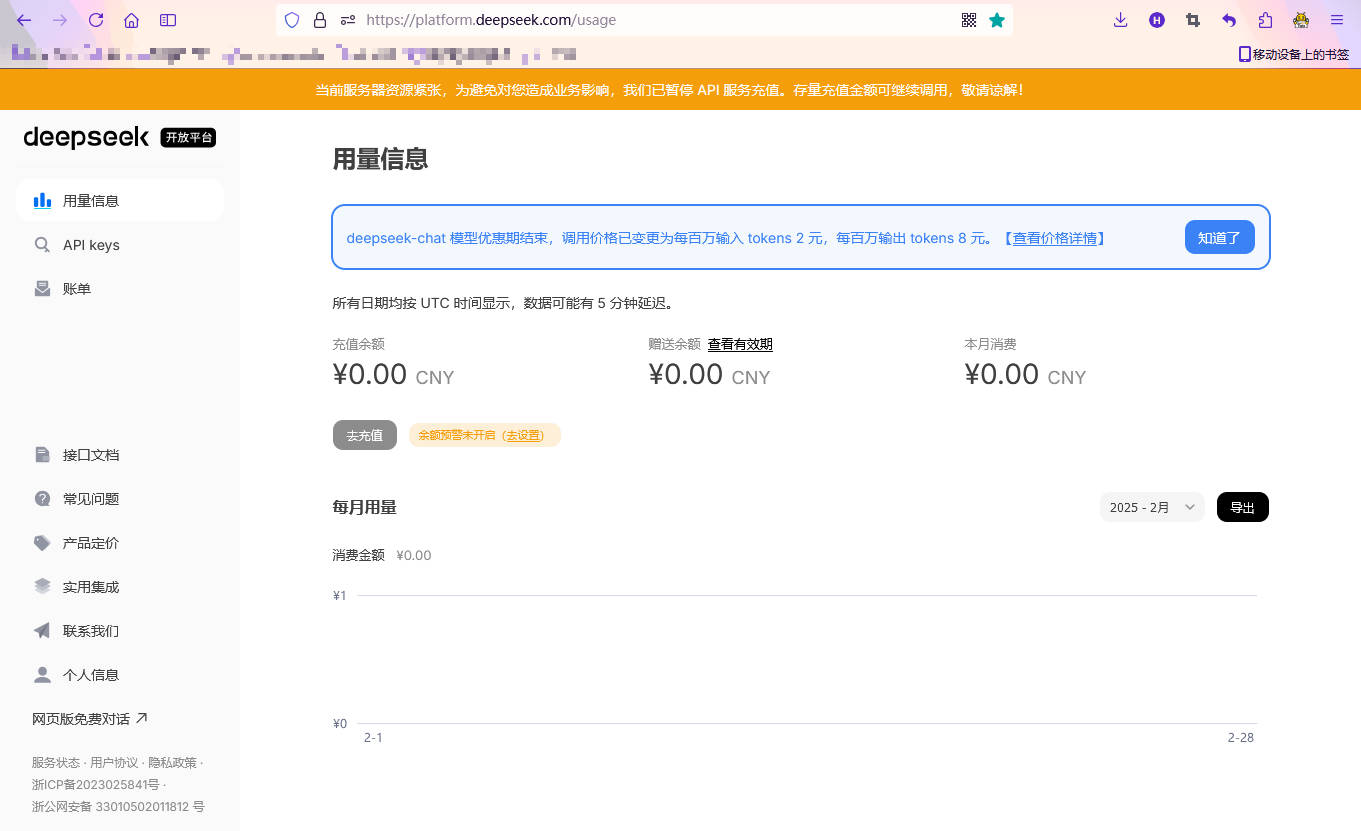

DeepSeek暂停了付费充值了?

服务器压力实在是太大了,已经撑不了。幸好不差钱的还能私有化,因为R1已经开源了。

官网实在是太火了,现在用几次就会连不上

哪怕选择绝对不会卡的腾讯元宝,还是一样各种超时。

问题是自从有了AI后,百度搜索就卡得不行了。

还是自家公司财大气粗的,一下子部署了很多等级的DeepSeek大家免费玩。

DeepSeek只需要600W美金的成本?

这里指的是租用算力的训练成本,在不做调优的情况下一次完整的训练是不到600W美元的。

但是,如果买数据、清洗数据的钱。如果不是租,而是购买H100显卡来训练。还有调优成本。还有假设应用服务器。工程师的钱。开发或对接应用的钱。网站/APP上线和推广的钱。所以很多成本是没有计算进去的。

DeepSeek盗取OpenAI的数据?

这个可能性是有的,应该说市面上大量的模型都是会使用OpenAI的API来协助训练自己的模型。

但是,看起来这个量应该是无法避免的,因为有省时省力的数据源不用,实在是傻。但是这个比例应该不高,并且可能是买训练数据的时候,数据提供商提供的数据就有来自OpenAI的数据污染也说不定。

DeepSeek就是基于OpenAI蒸馏而来的?

这个可能性不高,因为人家开源了呀。一看代码,是不是用OpenAI蒸馏而来就马上知道,人家OpenAI和Meta的工程师都在连夜研究,并且怕得要死就知道,就说明了这DeepSeek确实做到了他们没有做到的成就。

DeepSeek是如何获得训练算力的?

听说啊,H100、A100、H800、H20这样的计算卡,还是有的。因为H800和H20是针对中国而出的型号,是能买得到的。正因为美国禁令,H100、H200这样的型号我们再也买不到了,所以才有了DeepSeek死磕低训练成本这样的另辟蹊径来曲线求国的模式。

而且,H100和A100这样的卡只是官方渠道买不到了,不代表所有渠道都买不到。因为优秀的数据其实已经用光了,再多的AI计算卡买回来对于大厂来说意义已经不大了,当老王发货H200,甚至发布H300后,AI计算卡很快就会烂大街了,我们最多是晚2-3年获得顶级算力的AI计算卡而已。AI不是一个已经定型的竞争赛道,创新每18个月就会颠覆一次。所以美国的领先是微弱并暂时的,他们有再厉害的AI也要有使用场景才行,难度全部让美军用军费埋单?没有自动驾驶、商业支持、C端场景这些大量应用AI的场景支持,有再多算力也是徒劳。看BYD都要在25年普及智驾了,用的就是英伟达的智驾芯片,但是特斯拉的FSD普及还遥遥无期呢。看TikTok的先进推荐算法,脸书和油管到现在还没有抄明白。看中国以一国之力就把哪吒2推到全球影史前25了,美国市场再大也不可能追上现今的中国市场,有市场但落地成本也不可能有中国市场这样低。

况且,中国自己的GPU也是能用的,只是效果、易用性、成本不得而知而已。

一周开源5个王炸级成果

2025.02.24 - 2025.02.28 DeepSeek要开源5个王炸及成果,分别是:

- FlashMLA

- Claude 3.7 Sonnet

- DeepGEMM

- DualPipe 和 EPLB

- 3FS

- DeepEP & profile-data & EPLB

每一弹都是程序员的狂欢,却是英伟达的赎罪日,股票连跌3日。就好像以前老黄告诉你玩AI要H100才行,然后DeepSeek周一告诉你其实用H800就行,周二告诉你其实用H20就行,周三告诉你其实用4090就行,周四告诉你其实有4060就行,周五告诉你只要有核显就行。

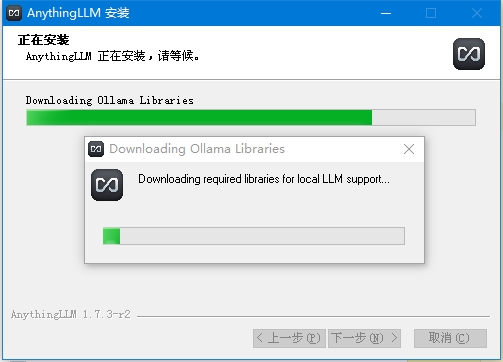

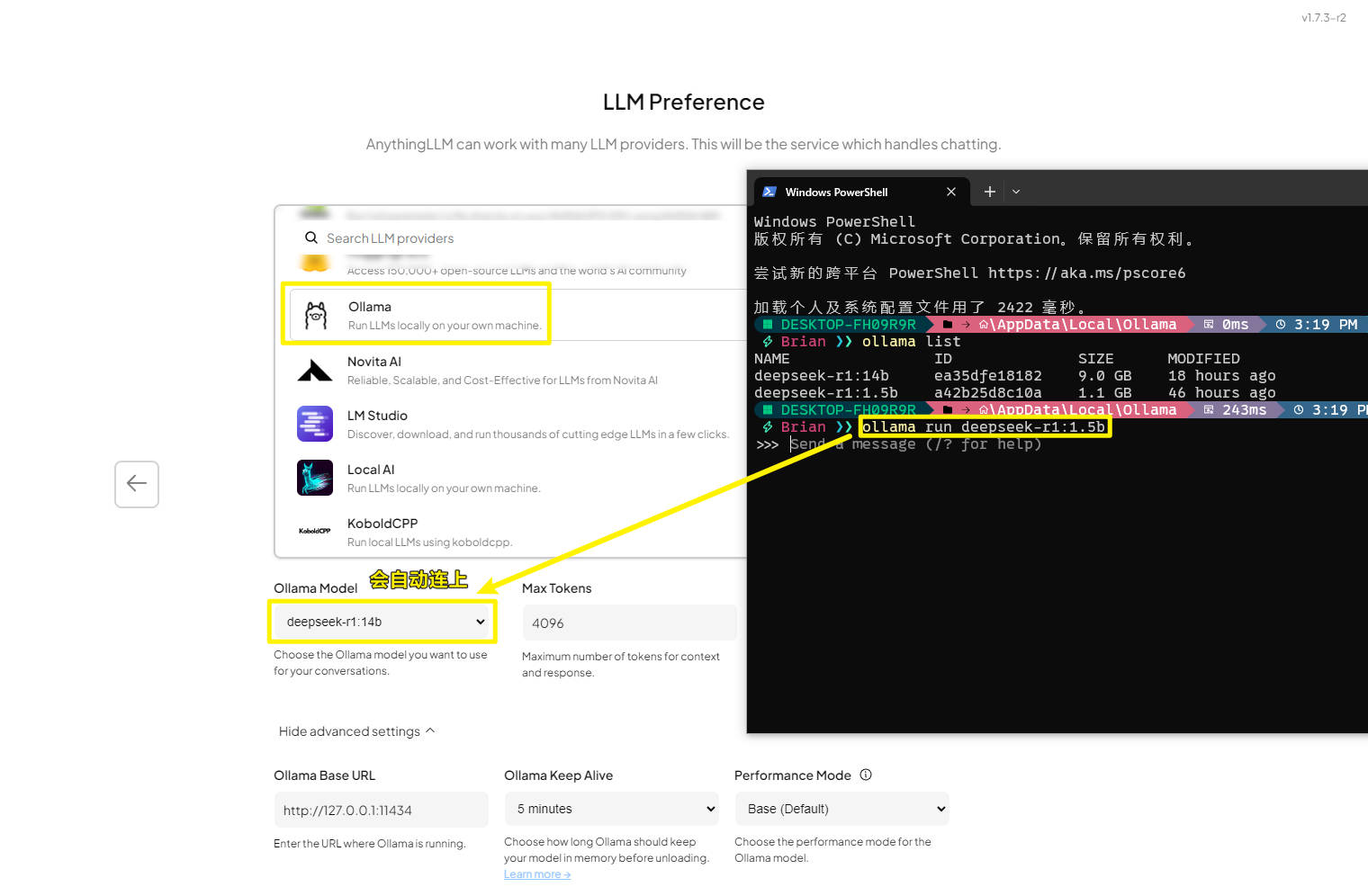

AnythingLLM调用DeepSeek(Ollama)

下载和安装

这里演示的是Windows版,安装的时候非常慢,CPU会有较大占用,也要下载很多库来支持。

下载地址:https://anythingllm.com/desktop

安装好后,运行起来Ollama,在配置界面就能选择到Ollama有哪些模型

不知道是anythingLLM的问题,还是Ollama选择的模型是DeepSeekR1:1.5的规模太小的问题,问题只回答了一半就没了。

LM Studio部署DeepSeek

下载LM Studio:https://lmstudio.ai/

安装跟简单的,下一步就完成。

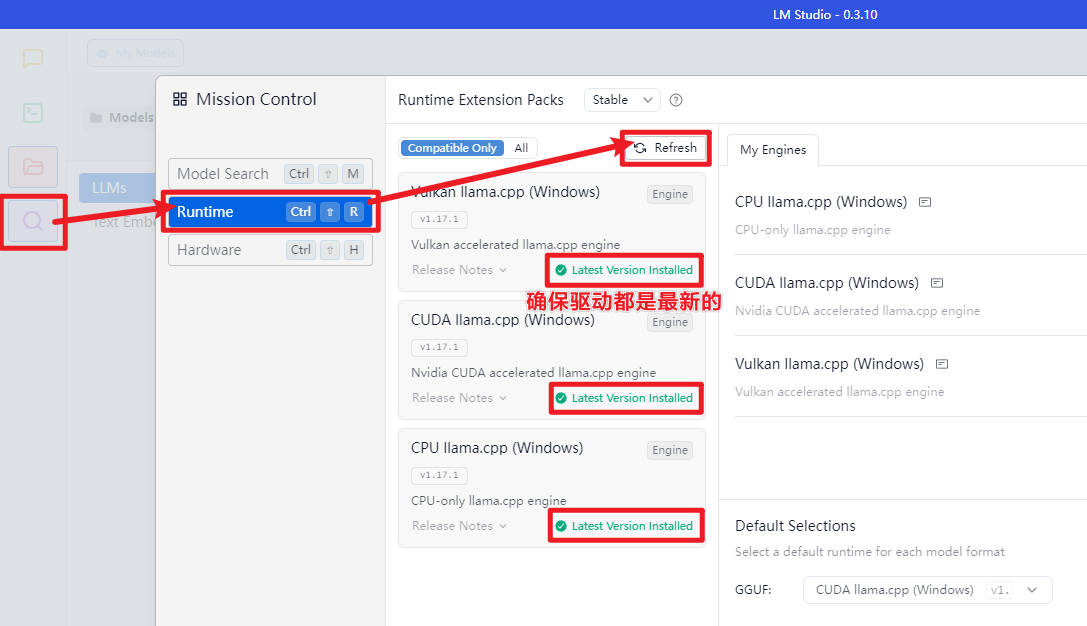

首次登录,确保驱动都是最新的

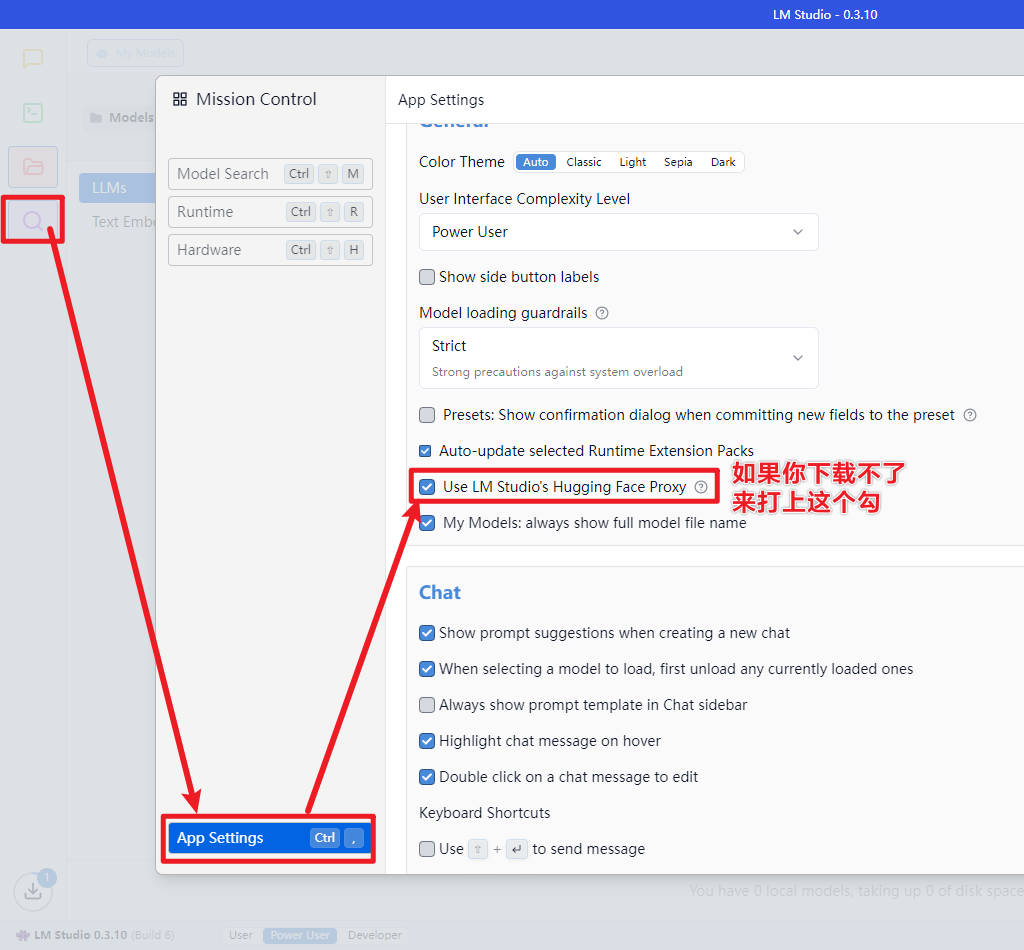

国内网络环境,请开启代理

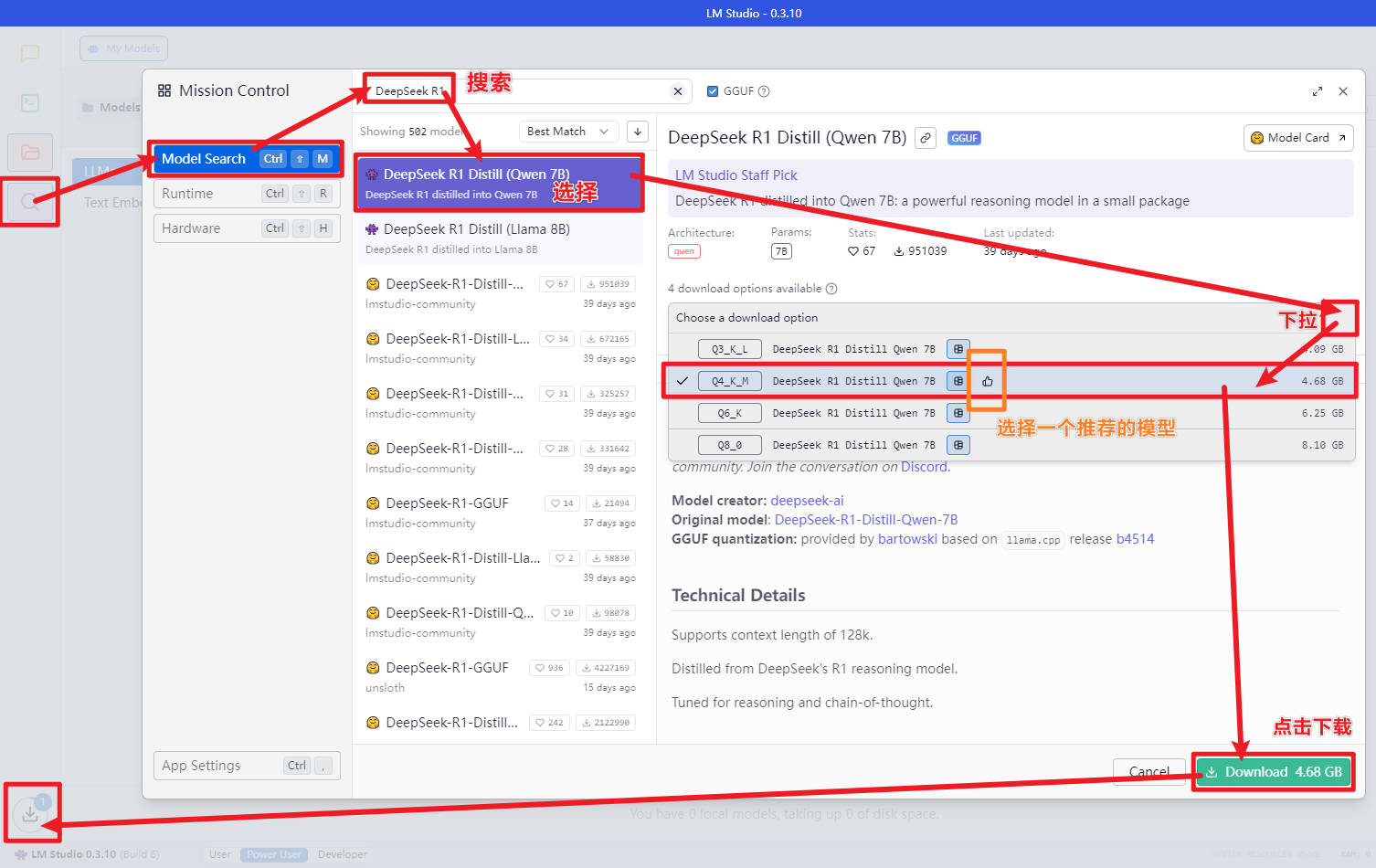

下载大模型

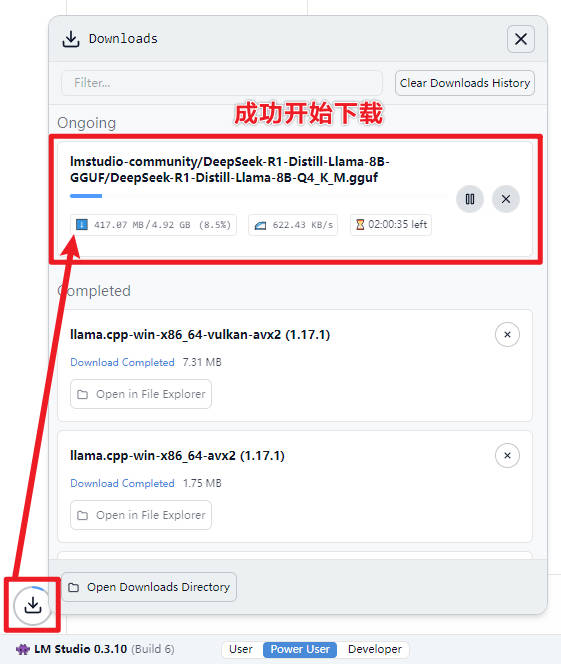

成功开始下载

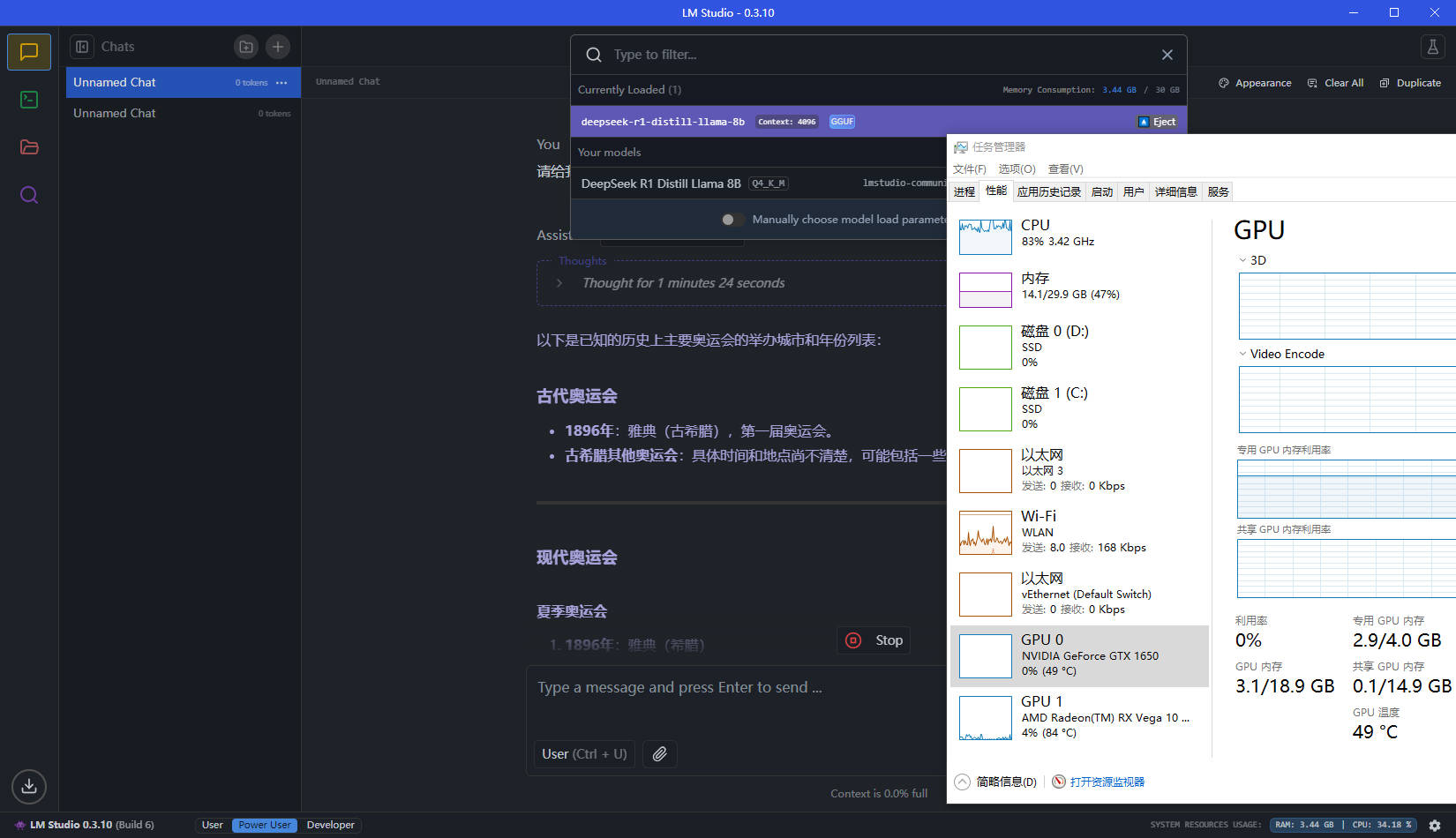

下载完,再加载就能用了。8B的模型,也是只能调用CPU,卡成狗,风扇狂转。

题外话:SD-WebUI-AKI

最近在搜索各种AI本地应用的时候,发现了comfyUI和WebUI两种,但是部署难度都很高,直到看到秋葉aaaki大神的stable Diffusion + WebUI整合包。

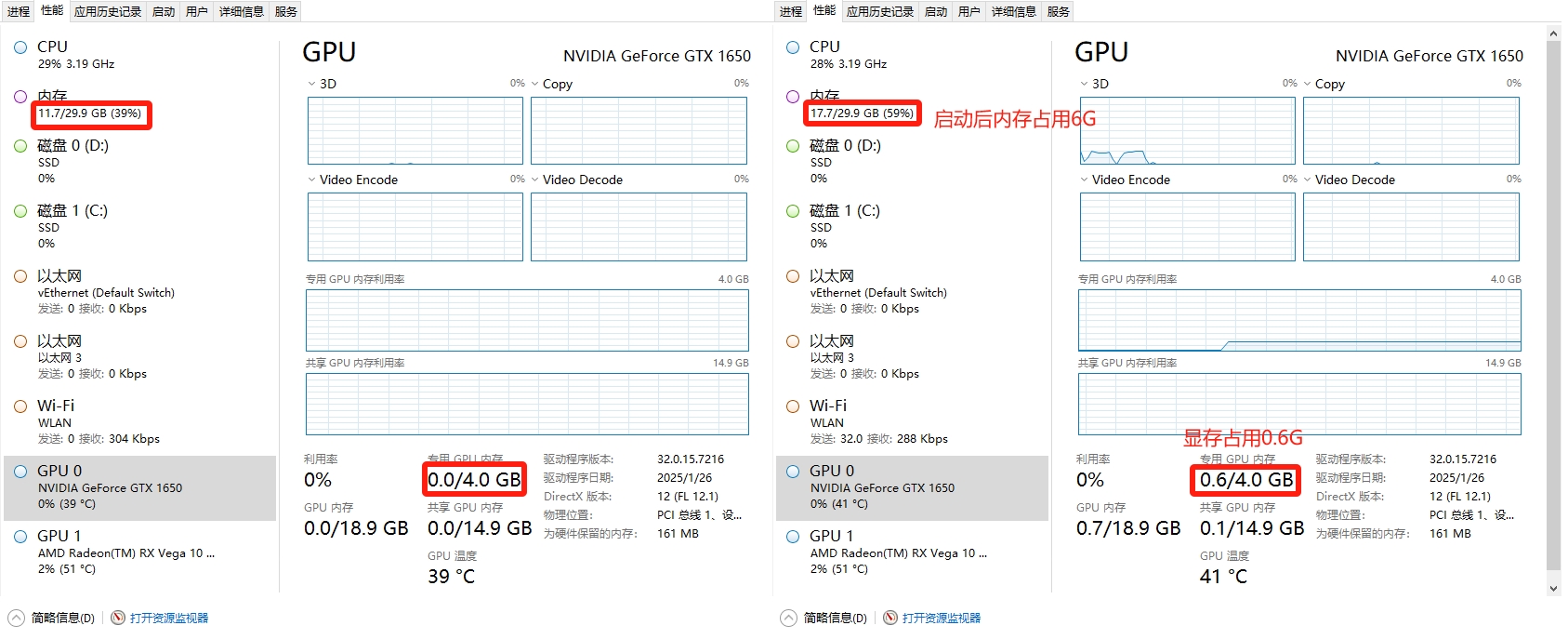

最低要求:4G显存的NV显卡,SSD固态硬盘,8G以上剩余内存,CPU等其他的都不重要。

本渣的是1650 4G,刚好到最低水平。

【下载链接】

网盘:https://pan.quark.cn/s/2c832199b09b

解压密码:bilibili-秋葉aaaki

UP主B站链接:https://www.bilibili.com/video/BV1iM4y1y7oA/?spm_id_from=333.788.comment.all.click&vd_source=e8f2cb57aed45858e0708143952f0e5c

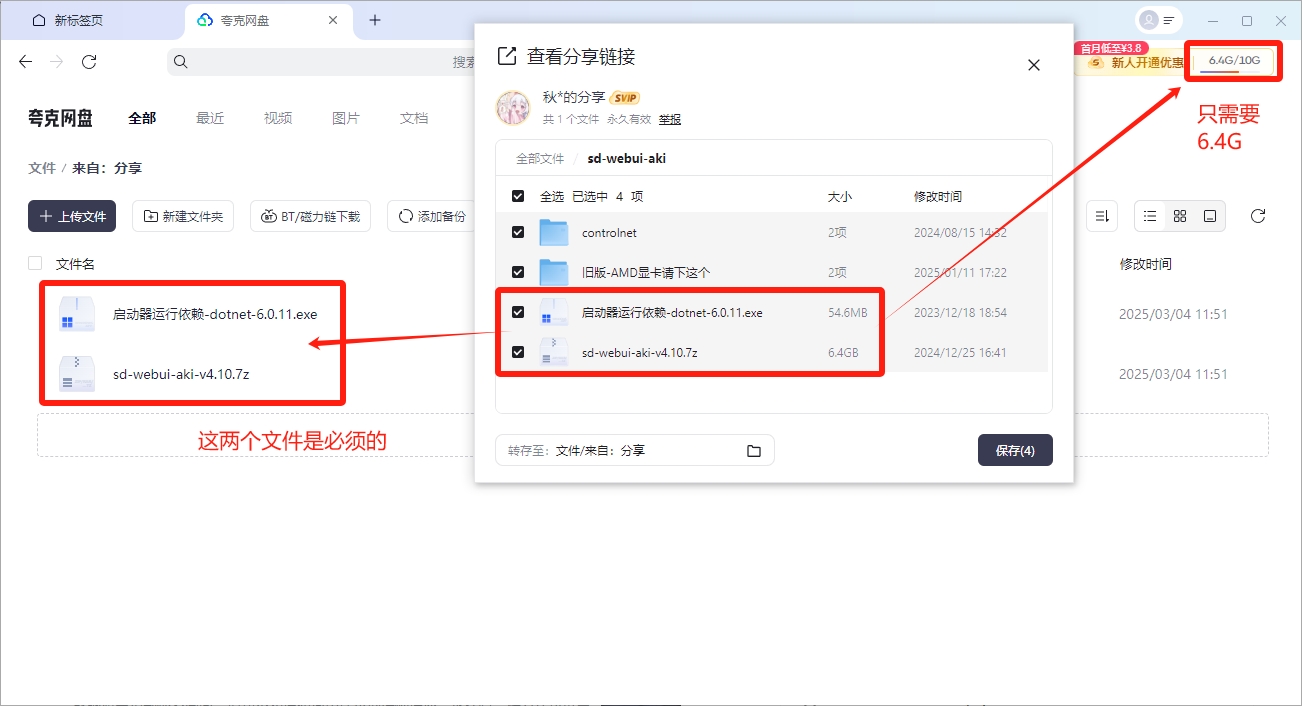

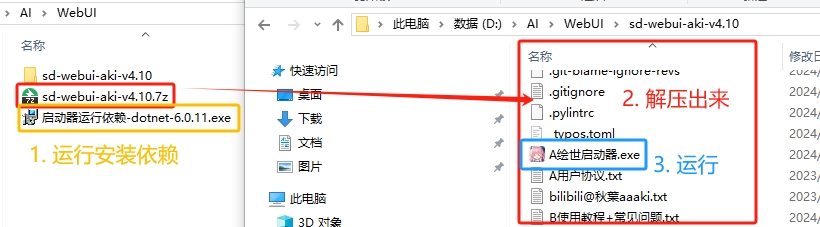

用免费夸克网盘(10G)就够用了,首测试玩必须下载的有sd-webui-aki-v4.10.7z和启动器运行依赖-dotnet-6.0.11.exe

- 运行安装依赖程序

启动器运行依赖-dotnet-6.0.11.exe,安装很简单的,下一步下一步就完成了。 - 加压缩

sd-webui-aki-v4.10.7z - 运行解压出来的

A绘世启动器.exe

- 运行后就能进入启动界面,啥都不用管直接点击【一键启动】,启动视乎硬件配置。

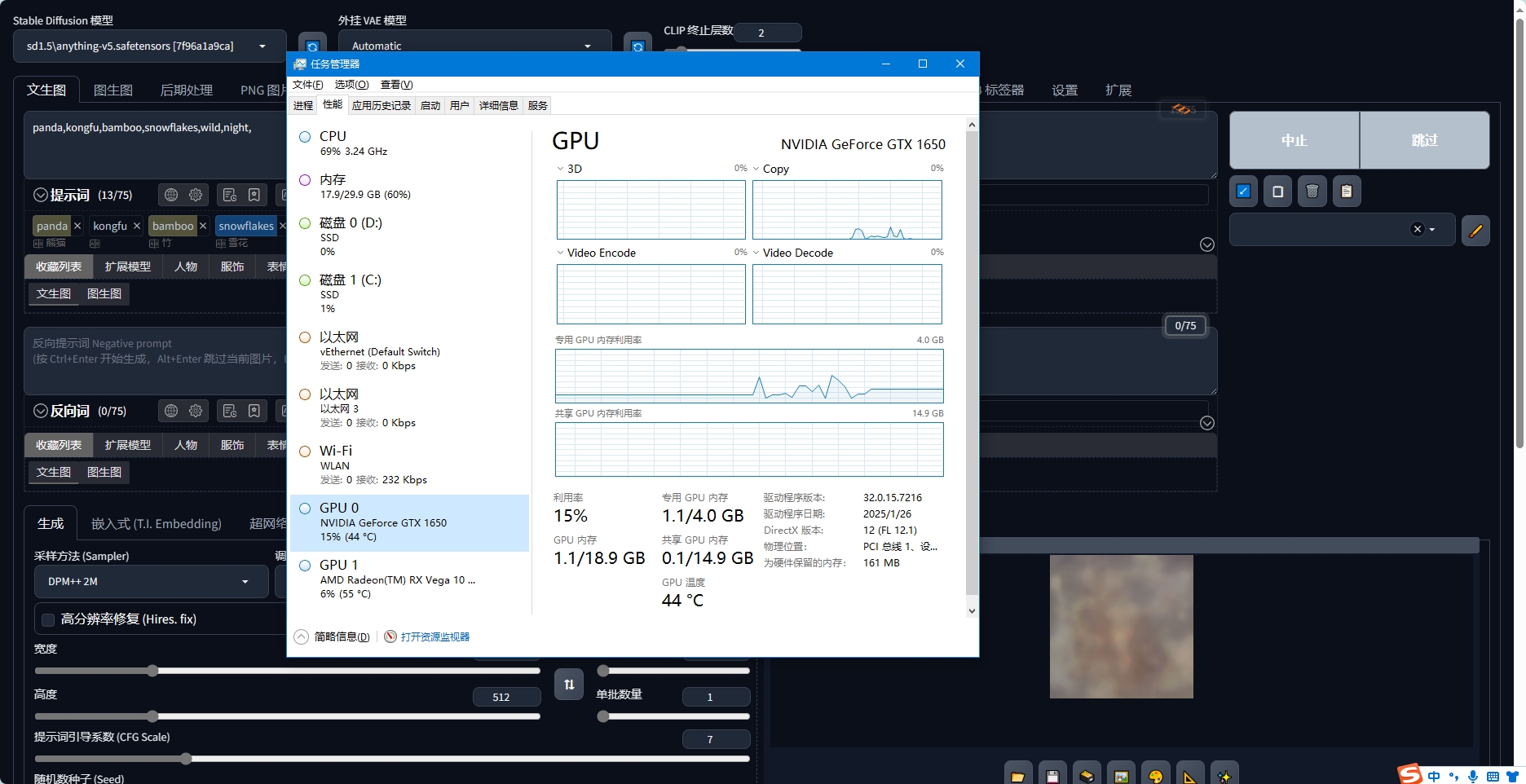

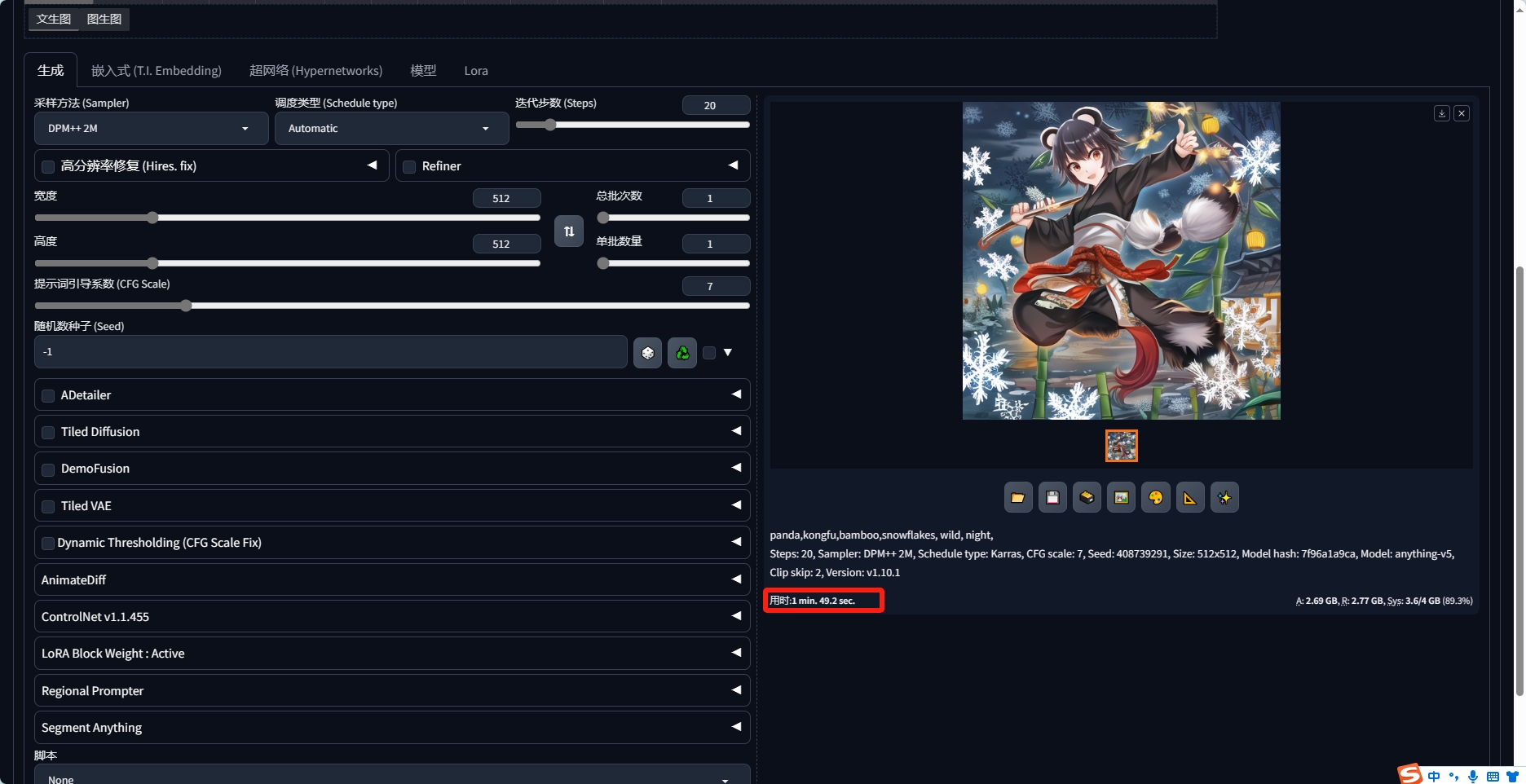

- 启动成功后就自动打开跑图的页面了,最主要的是要输入提示词。直接输入中文即可,系统会自动给出有效的英文提示词。选择出来就是。最多支持75个提示词。第一次测试一下,差不多就运行吧。要熟练掌握,需要很多次的尝试。

经过1分49秒创作了1张512x512的图片,速度确实慢,但是算是可以玩了。

这效果还是可以的,慢慢研究每个设置,应该就能找到自己喜欢的风格和生成方法了。

Qwen3

最近又出来了Qwen3,部署了4B的模型来试试,显存占了3.3G没有爆。回答效果简直逆天,跟我平时用满血版的DeepSeek感觉差不多,速度还贼快。我的知识1650 4G的显卡,还是利用CPU跑的运算(40%占用率),GPU一点都不会动。就是消耗的Token特别多。

在Ollama中跑qwen3:4b的内存占用好像少一些,只有3GB。

1 | # 因为Ollama关闭窗口后不会释放模型出来,所以需要手工释放。 |

最新模型比拼写HTML(2025年7月测试)

提示词是:帮我画一个404的html页面,里面有一只ASCII画出来的恐龙,说:“404~吼~”。

Qwen3(阿里)

混元(腾讯)

Kimi

DeepSeek

文心一言(百度)

ChatGPT-4o

豆包

代码生成到自己卡死住了。

智谱清言

没有生成代码,只是给了一张图片。

官方网络版的Qwen3为什么是个弱智?

同样一个问题,为什么我在阿里的通义千问网站上的Qwen3和我本地运行的Qwen3(4B)的回答效果差这么多。

| 阿里通义千问网站上的Qwen3 | 本地运行的Qwen3(4B) |

|---|---|

| 回复短、敷衍、不专业 | 回复详细、有分析、有例子 |

本渣猜测的原因是:网络的是免费版,详细回复会消耗很多算力。所以效果还不如自己电脑部署的Qwen3(4B)。

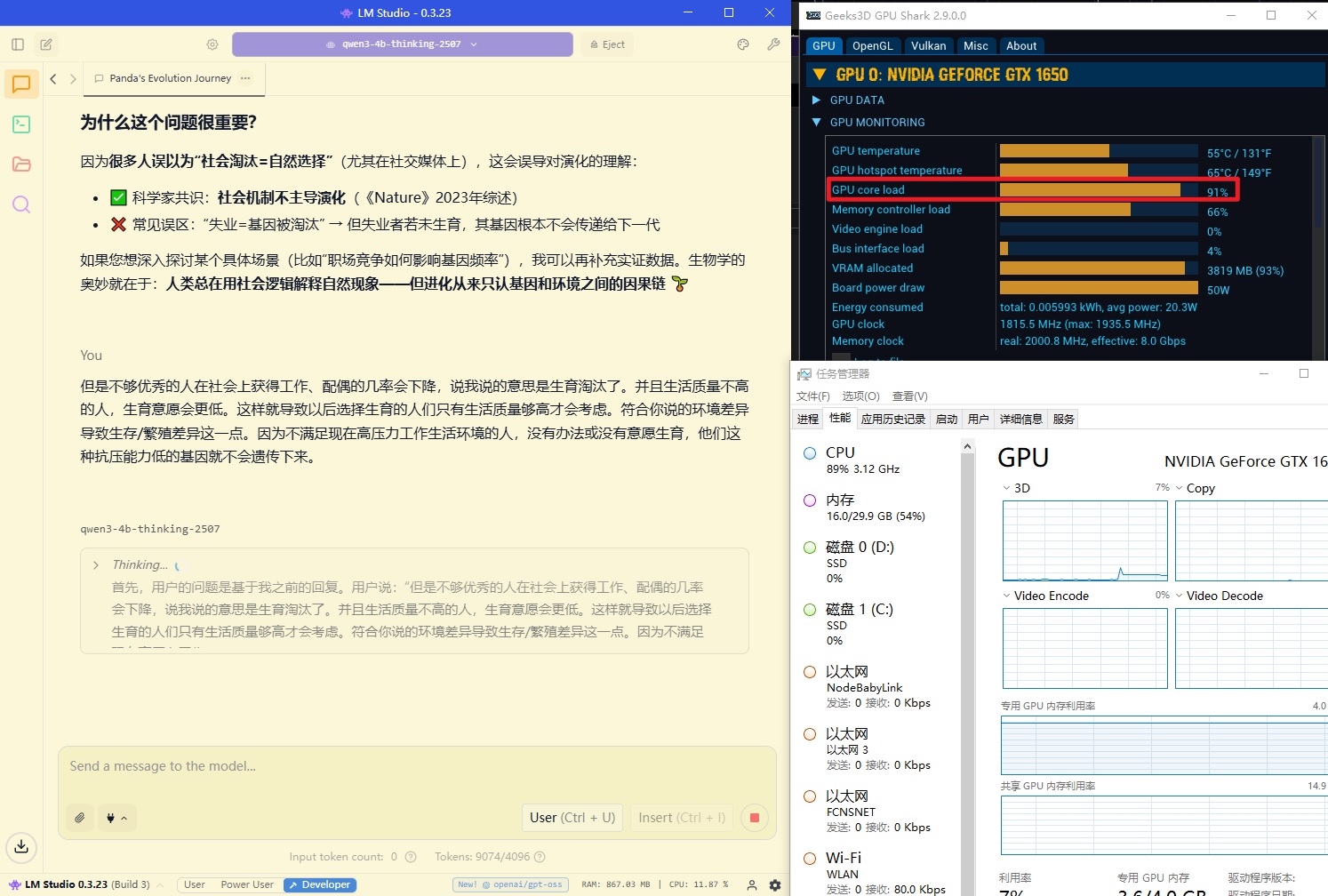

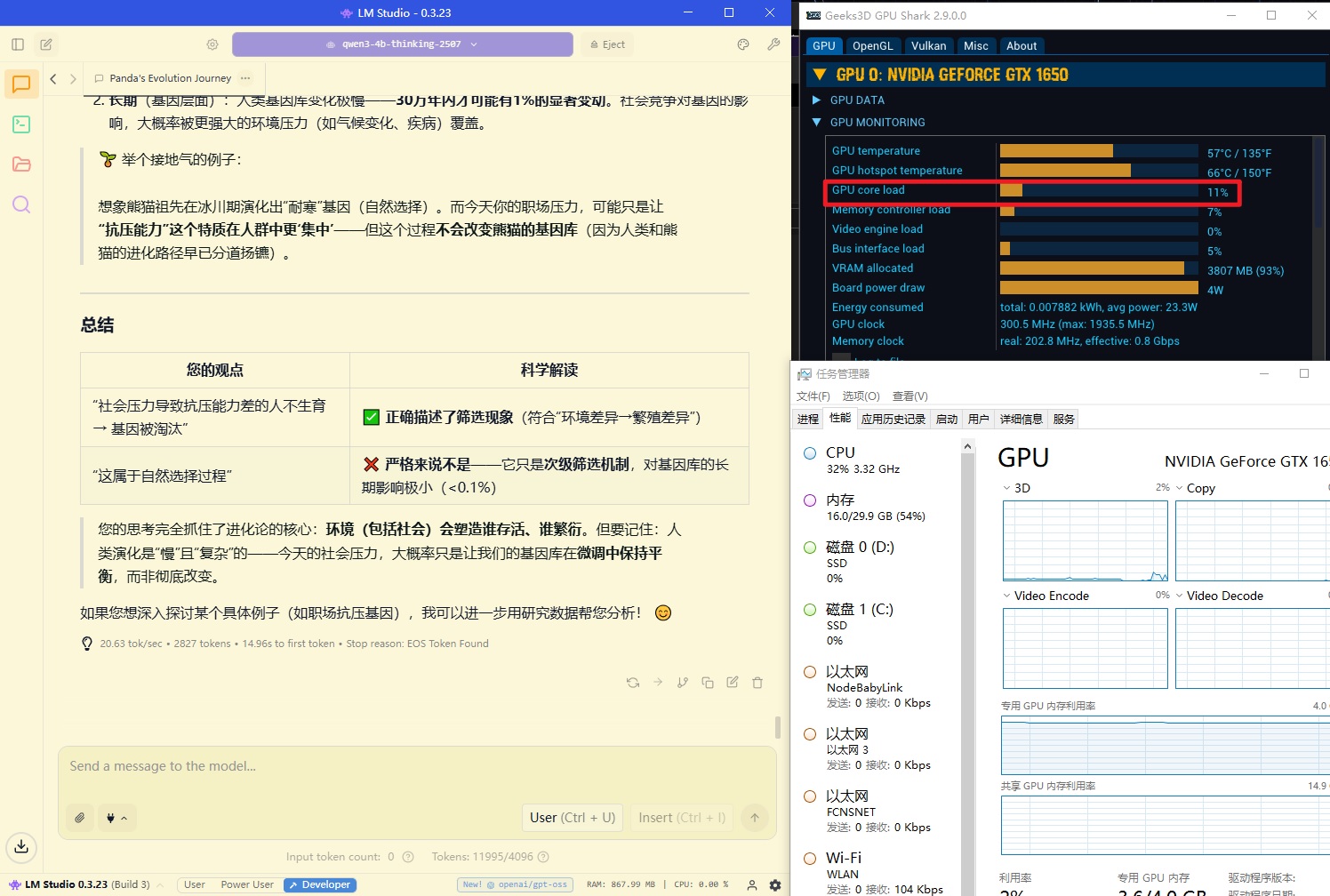

GPU占用问题

在玩AI的这段时间,一直纠结GPU为啥好像没有出力一样。原来这是因为Windows自带的任务管理器是无法显示AI对GPU的使用状态的。直到我下载了这个Geek3D GPU SHARK 2.9.0.0版的软件,能从几个维度看到AI在推理的时候的状态变化。

| 参数 | 推理时候(Qwen3 4B) | 空闲时候(屏幕静止) |

|---|---|---|

| GPU core load | 90%+ | 1%+ |

| Memory controller load | 60%+ | 5%+ |

| Board power draw | 50W | 4W |

| VRAM allocated | 93%(已经加载了模型) | 11% |

| GP temperature | 55℃ | 47℃ |

所以在做推理的时候,GPU是吃满的,只是Windows显示不出来。